Pengaturan robots.txt dan tag tajuk robot khusus di Blogger bertujuan agar mesin pencari (search engine) mudah merayapi (crawling) blog, sehingga artikel lebih cepat terindex. Jika diatur dengan benar, maka blog akan menjadi SEO friendly. Sebaliknya, jika kurang tepat maka blog akan diabaikan oleh mesin pencari yang mengakibatkan artikel tidak muncul di hasil pencarian.

Oleh karena itu dibutuhkan settingan yang aman agar blog tidak mengalami efek negatif. Sebenarnya tidak perlu disetting pun robots.txt ini sudah aktif dengan sendirinya sejak blog pertama kali dibuat. Penerapan default inilah yang paling aman. Tapi kalau kamu mau melakukan konfigurasi tambahan, maka ikuti tutorial cara setting robots.txt di Blogger dibawah.

1. Cara Setting robots.txt Khusus di Blogger Agar SEO Friendly

Buka menuSettings » Search preferences » Crawlers and indexing » Custom robots.txt » klik Edit.Pada pilihan

Enable custom robots.txt content? pilih Yes. Selanjutnya masukkan settingan robots.txt yang aman berikut ini.User-agent: *

Allow: /

Disallow: /search

Sitemap: https://www.blogkamu.com/sitemap.xml| Nama | Keterangan |

|---|---|

User-agent |

Nama robot mesin pencari (web crawler software). |

Disallow |

Direktori atau halaman yang TIDAK DIIZINKAN DIRAYAPI oleh user-agent. |

Allow |

Direktori atau halaman yang DIIZINKAN DIRAYAPI oleh user-agent. |

Sitemap |

Lokasi sitemap. Ganti dengan alamat blog kamu. |

| Nama | Keterangan |

|---|---|

User-agent: * |

Mengizinkan semua jenis user-agent untuk merayapi semua direktori, kecuali semua URL yang memiliki direktori /search. Contoh: https://www.blogkamu.com /search?q=cara+mempercepat+bloghttps://www.blogkamu.com /search/label/CSShttps://www.blogkamu.com /search?updated-max=2018-01-30T23%3A00%3A00%2B07%3A00&max-results=8#PageNo=2 |

Sitemap: https://www.blogkamu.com/sitemap.xml |

Memberitahukan pada robot perayap dimana lokasi sitemap berada. |

Setelah selesai, klik tombol Save

1.1. Mencegah Perayapan Pada URL Halaman Tertentu

Nah, jika ada halaman khusus yang tidak ingin dirayapi, kamu tinggal menambahkannya pada Disallow. Contohnya seperti ini:User-agent: *

Allow: /

Disallow: /search

Disallow: /p/kontak-lama.html

Disallow: /2009/01/test-postingan-pertama.html

Sitemap: https://www.blogkamu.com/sitemap.xmlUntuk mengecek apakah robots.txt sudah berubah dan sama dengan settingan diatas, buka URL berikut.

https://www.blogkamu.com/robots.txt2. Mengatur Custom Robots Header Tags Di Blogger

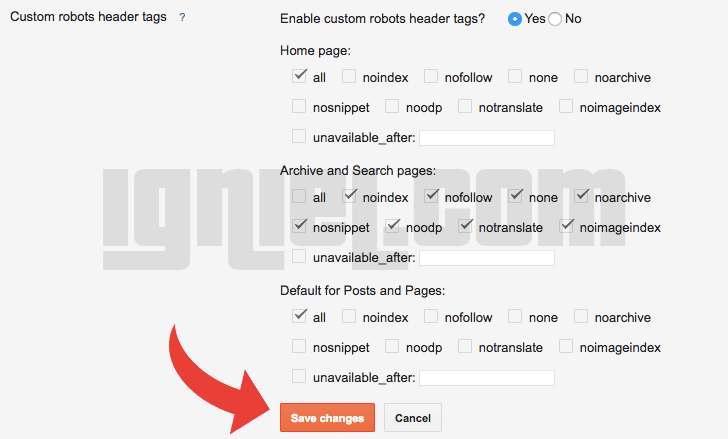

Masih di menu yang sama yaituCrawlers and indexing, di bagian Custom robots header tags klik Edit. Pada pilihan Enable custom robots header tags? pilih Yes. Samakan pengaturannya dengan gambar dibawah ini.

Keterangan:

- Mengizinkan mesin pencari untuk merayapi semua direktori homepage (beranda), post, dan pages (halaman statis).

- Tidak mengizinkan mesin pencari untuk merayapi direktori archive (arsip) dan search (pencarian) seperti yang sudah dijelaskan diatas.

3. Kenapa Direktori Achive (Arsip) dan Search (Pencarian) Tidak Dirayapi?

Karena direktori kedua halaman itu mengandung URL yang depannya sama.Sudah dicontohkan diatas, direktori hasil pencarian adalah:

https://www.blogkamu.com/search?q=cara+mempercepat+blog

https://www.blogkamu.com/search/label/CSS

https://www.blogkamu.com/search?updated-max=2018-01-30T23%3A00%3A00%2B07%3A00&max-results=8#PageNo=2dll masih banyak lagi sesuai jumlah artikel.

Format penulisan URL setelah homepage

https://www.blogkamu.com selalu sama, yaitu diikuti oleh /search. Melarang robot merayapi direktori ini bertujuan untuk mencegah konten duplikat yang bisa berakibat terkena penalti dari mesin pencari.Saya kira sudah jelas ya soal setting robots.txt dan custom robots header tags di Blogger ini. Saya bukan ahli SEO, jadi kalau ada yang salah harap koreksi dengan cara memberikan komentar dibawah.